Cerca nel blog

Unisciti a me in questo viaggio di speranza e solidarietà, immergiti nella mia storia di resilienza. Il mio romanzo autobiografico "Lasciato Indietro" è un tributo alla forza dell'essere umano, che non si arrende, che cerca di migliorare se stesso e il mondo. Con il tuo aiuto, faremo la differenza: "1.000 copie per 1.000 euro" alla TIN del Bambino Gesù di Roma, dove opera la mia amata Alice, un medico ed una donna straordinaria. Segui il mio nuovo sito: https://www.dinotropea.it/

TRANSLATE

Viaggi Tra le Pagine

- "Cristoforo Russo: Un’Eterna Sinfonia" (15 aprile 2024)

- Sanremo Writers 2025: un sogno che diventa storia – Dino Tropea

- “Lasciato Indietro”: Il Viaggio Straordinario di una Storia Vera

- Tra Onde e Parole

- Dicono di Lasciato Indietro

- Presentazione Lasciato Indietro

- Dallo zecchino d’oro a Dino Tropea: amicizia e salvezza del pianeta.

- Il Regno Sommerso di Coralyn

- Amore senza dipendenza: vivi, ama, resta te stesso!

- La vera fonte della felicità

- Prosapia: La Forza della Nostra Storia nei Temi di Lasciato Indietro, Scrivere al Futuro ed Il regno sommerso di Coralyn

- A chi mi ha fatto più male in assoluto: dico grazie

In Evidenza

- Ottieni link

- X

- Altre app

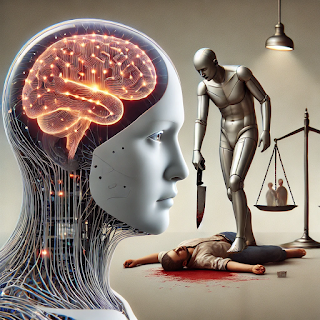

Quando l'IA fa più rumore del coltello

Il caso di Marco Magagna e il paradosso di una società che si indigna per i mezzi, non per i fatti.

Raccontare una tragedia come l'omicidio di Marco Magagna, ucciso con una coltellata dalla compagna Stella Boggio, dovrebbe far riflettere. Ci aspetteremmo di discutere della violenza, delle dinamiche di coppia che possono degenerare, o della questione della legittima difesa invocata da lei. Ma qualcosa di inaspettato ha cambiato il focus del dibattito.

L'Avatar, una voce generata da un’intelligenza artificiale, ha raccontato i fatti con precisione, chiarezza e toni professionali. Nulla di meno e nulla di più rispetto a quello che avrebbe fatto un giornalista umano. Eppure, i commenti sotto il video non si sono soffermati né sulla vittima né sul crimine. No, si è parlato solo della narratrice virtuale. “È una macchina a raccontarci queste cose?” “Perché dovremmo accettare un'IA al posto di una persona reale?”

Quasi nessuno ha commentato il fatto in sé. Silenzio sulla tragedia, sulla morte improvvisa e violenta di un uomo. Nessuno ha discusso della possibile legittima difesa o del dramma umano che si nasconde dietro questo gesto estremo. Il coltello è passato in secondo piano. Il problema, per molti, è diventato chi ha raccontato la storia.

La paura dell'IA o della verità? È qui che emerge un paradosso interessante. Se una fake news è raccontata da un giornalista umano, ci si scaglia sul contenuto, sulla falsità, sulla manipolazione dell’informazione. Ma quando un fatto vero, confermato da copertura mediatica nazionale, è riportato da un’IA, il problema diventa lo strumento e non ciò che viene narrato.

Questo comportamento ci dice molto sulla nostra società. Siamo più concentrati sul contenitore che sul contenuto. In un mondo in cui l’attenzione è sempre più breve e il giudizio sempre più immediato, spesso perdiamo di vista ciò che conta davvero. Il messaggio si svuota, perché la nostra attenzione si blocca sulla forma.

Un problema di fiducia. La reazione al racconto dell'Avatar evidenzia un tema più ampio: la sfiducia nei confronti delle nuove tecnologie. Quando un’intelligenza artificiale racconta un fatto di cronaca, c’è chi vede un attacco alla professionalità umana. Ma è davvero così? Una voce virtuale, calibrata per essere chiara, precisa e imparziale, può forse minare la verità più di quanto già faccia il sensazionalismo di alcuni media tradizionali?

Il paradosso è evidente: ci indigniamo per una macchina che racconta i fatti, ma accettiamo senza troppe domande le manipolazioni emotive di alcune trasmissioni televisive, dove il racconto è spesso costruito per catturare l'audience piuttosto che informare.

Un vuoto empatico. Forse, il vero problema non è l’IA, ma noi. La nostra incapacità di andare oltre il “chi” e concentrarci sul “cosa”. Questo caso dimostra come spesso la nostra attenzione sia attratta dal superfluo. Nel silenzio sui fatti e nel clamore sui mezzi, si nasconde un vuoto di empatia. La morte di un uomo, il dramma umano di chi resta, il tema della violenza domestica o delle dinamiche di coppia tossiche: tutto questo è passato inosservato.

Cosa ci dice questo sulla nostra capacità di provare empatia? Se un uomo viene ucciso con una coltellata, non dovremmo forse discutere della tragedia umana, delle sue cause e delle sue conseguenze? Invece, sembriamo più interessati a stabilire se la voce che racconta il fatto sia “degna” di farlo.

La vera domanda. Questa vicenda ci spinge a riflettere su una domanda fondamentale: chi racconta la storia è davvero più importante della storia stessa? Possiamo permetterci di giudicare il mezzo più del messaggio, in un’epoca in cui la verità è sempre più fragile e i fatti rischiano di essere travolti dalle opinioni?

La narrazione di un’IA non è perfetta, ma può essere un modo per riportare l’attenzione sui fatti, senza interferenze emotive o manipolazioni. Non sarebbe più utile concentrarci sul contenuto, analizzarlo e discuterne, piuttosto che sprecare energie a giudicare chi lo presenta?

In Lasciato Indietro ho raccontato la mia esperienza personale di alienazione genitoriale, una vicenda che, come quella di Marco Magagna, ruota intorno al silenzio e alla mancanza di empatia. Troppo spesso le storie umane restano sullo sfondo, ignorate o giudicate solo superficialmente.

Proprio come nel caso dell'IA che racconta un fatto di cronaca, anche nella mia storia ho sperimentato l'indifferenza verso il contenuto reale del mio dolore. Le persone si fermavano ai dettagli di superficie: chi avesse torto o ragione, i piccoli elementi di contorno, senza mai andare al cuore della questione.

Il punto è lo stesso: ci concentriamo sul “come” e sul “chi” più che sul “perché”. Siamo distratti da questioni secondarie mentre le vere storie, quelle che parlano di sofferenza, ingiustizia e resilienza, restano dimenticate.

Forse, raccontare con un’intelligenza artificiale è una provocazione, ma anche un modo per chiedersi: cosa succede quando diamo più importanza al mezzo che al messaggio? Una domanda che vale sia per un racconto mediatico sia per una storia personale come la mia.

Conclusione. Il caso di Marco Magagna e del racconto dell'Avatar non è solo una cronaca nera. È uno specchio che riflette le nostre paure, le nostre distrazioni e la nostra incapacità di concentrarci sull’essenziale. Forse, più che aver paura dell’intelligenza artificiale, dovremmo preoccuparci di ritrovare il nostro senso critico, la nostra empatia e la nostra capacità di discernere ciò che conta davvero.

Citazione suggerita: "Non è l’IA il problema. Il vero problema siamo noi, quando dimentichiamo di dare importanza ai fatti e non a chi li racconta."

#IA #Cronaca #MarcoMagagna #HedraAvatar #Tecnologia #Empatia #Verità

- Ottieni link

- X

- Altre app

Post più popolari

Lasciato Indietro: “Trascendere Oltre i Limiti Un Tributo a Cristoforo Russo"

- Ottieni link

- X

- Altre app

L'Impatto delle Nuove Tecnologie sulle Relazioni Umane parte 2.

- Ottieni link

- X

- Altre app

Commenti

Posta un commento